Abstracts

Résumé

Cet article examine un dispositif d’évaluation des enseignements par les étudiants (EEE) en analysant les choix des équipes pédagogiques concernant les questionnaires qu’elles conçoivent. Cette étude est menée afin d’étudier la place possible de l’EEE dans le cadre de l’évaluation-conseil. En effet, pour que l’EEE soit utile aux enseignants, il convient que les questions posées aux étudiants permettent aux enseignants comme aux professionnels de l’accompagnement de s’inscrire dans une logique d’évaluation-conseil. Les résultats montrent leur intérêt dans ce cadre en fournissant aux enseignants des données qui leur permettent de conforter ou de modifier leurs enseignements. Ils soulignent également l’absence de recueil de données en lien avec certaines dimensions de la relation pédagogique (notamment les difficultés étudiantes et les interactions enseignant-étudiant), ce qui pose la question de la perception de l’enseignement chez les enseignants-chercheurs en France.

Mots-clés :

- évaluation des enseignements par les étudiants,

- développement professionnel des enseignants,

- accompagnement pédagogique

Abstract

This article attempts to investigate a system of the teaching evaluation by students focusing on the choice of items made of teaching staff when designing the evaluation questionnaire. The purpose of this research is to study whether results of student evaluation of programmes may be used to ground professional advice to teachers. Items surveyed in the evaluation questionnaire should be selected specifically for the scheme to provide results on which to build advisory expertise for improvement of teaching practices. The results show which items provide useful information for teaching teams. They also highlight the absence of a series of items concerning student learning problems and teacher-learner relationships that questions the perception of teaching by academics in France.

Keywords:

- teaching evaluation by students,

- educational development,

- professional development,

- academic development

Resumo

Este artigo examina um dispositivo de avaliação do ensino pelos estudantes (AEE), analisando as opções das equipas pedagógicas na conceção dos questionários. O seu propósito é estudar o possível lugar da AEE no quadro da avaliação-conselho. Com efeito, para que AEE seja útil aos professores, convém que as questões colocadas aos estudantes permitam, tanto aos professores como aos profissionais de acompanhamento, a adoção de uma lógica de avaliação-conselho. Neste quadro, os resultados revelam interesse, fornecendo aos professores dados que lhes permitem confortar ou modificar o seu ensino, e sublinham, igualmente, a ausência de recolha de dados em articulação com certas dimensões da relação pedagógica (nomeadamente as dificuldades dos estudantes e as interações aprendente-professor), o que coloca a questão da perceção do ensino entre os professores-investigadores em França.

Palavras chaves:

- avaliação do ensino pelos estudantes,

- desenvolvimento profissional dos professores,

- acompanhamento pedagógico

Article body

Introduction

Dans le paysage universitaire français, les structures universitaires de pédagogie (SUP) sont peu nombreuses et récentes (Douady, 2012). Elles visent à développer la formation et l’accompagnement pédagogiques des enseignants-chercheurs dans un contexte nouveau. En effet, divers rapports ont insisté sur la mise en place d’une telle formation (Dejean, 2002 ; Espéret, 2001 ; Faure, Soulié, & Millet, 2005 ; Fréville, 2002 ; Petit, 2002 ; Romainville, 2004) de manière institutionnalisée et au-delà de l’apprentissage informel par les pairs. Des préconisations de formation pédagogique sont apparues, par exemple par le biais d’un syndicat des enseignants-chercheurs (SNESUP[1]) ou encore d’une association étudiante (UNEF[2]). Qui plus est, avec la réforme du statut des enseignants-chercheurs intervenue en 2009, le ministère de l’Éducation nationale, de l’Enseignement supérieur et de la Recherche dit vouloir prendre en compte l’investissement pédagogique dans la valorisation de la carrière[3].

Au-delà de cette mission de formation et d’accompagnement pédagogiques, quelques SUP sont aussi chargées de mettre en oeuvre l’évaluation des enseignements par les étudiants (EEE), dans un contexte où la faible implantation de l’EEE dans les universités françaises est régulièrement rappelée (Comité de suivi de la licence, 2011 ; Cour des comptes, 2012 ; Dejean, 2002), malgré son caractère obligatoire depuis 1997 – cette mission d’EEE pouvant être réalisée par d’autres services universitaires, tels que les pôles de pilotage ou de qualité, les observatoires des étudiants, etc., sans implication d’une SUP. Pour certaines SUP, l’EEE est faite sur la base du volontariat des enseignants dans le cadre de l’accompagnement pédagogique proposé, alors que d’autres sont impliquées dans une EEE institutionnalisée et parfois obligatoire. Devenue un instrument de gestion des carrières du personnel enseignant (évaluation administrative) à partir des années 1980 dans le contexte nord-américain, notamment en raison des contraintes budgétaires (Poissant, 1996), l’EEE a initialement été conçue comme un instrument de formation à destination des enseignants universitaires (évaluation formative). L’évaluation-conseil, qui découle de l’évaluation formative ou de « l’évaluation pour les apprentissages », est envisagée le plus souvent comme un apport d’information à visée formative pour les enseignants (Bedin, 2009 ; Lanarès, 2009 ; Jorro, 2007). Au-delà du constat ou du bilan, l’évaluation-conseil offre la possibilité à l’enseignant ou à l’équipe enseignante de s’engager dans une pratique réflexive qui s’inscrit dans un continuum allant de la réflexion jusqu’à l’action. Dans une telle perspective, l’EEE peut être considérée comme une source d’évaluation formative au service du développement professionnel des enseignants de l’enseignement supérieur, dans la mesure où elle vise à l’amélioration de l’enseignement de chaque enseignant. C’est le cas en France, où l’EEE n’est pas un outil de gestion de carrière, mais un outil d’information pour les seuls enseignants et enseignants-chercheurs, grâce notamment au caractère confidentiel de ses résultats, garanti par la loi française. Cependant, le caractère formatif de cet outil reste à débattre, car il est fortement lié aux questions qui sont posées et aux comportements des enseignants-chercheurs vis-à-vis des résultats. Par exemple, Rege Colet et Durand (2005) ont mis en avant le fait que certains enseignants se limitent parfois à regarder les comptes rendus des évaluations relatant les prises de position des étudiants. Pour que le couplage évaluation et conseil puisse jouer son rôle, il est nécessaire que les enseignants puissent tirer des savoirs des résultats obtenus aux questions posées aux étudiants dans le cadre de l’EEE. L’évaluation-conseil peut ainsi s’inscrire dans une logique de développement professionnel des enseignants en s’appuyant sur une réflexivité du praticien (Lanarès, 2009). Or, cette dernière suppose bien souvent des conseils ou de l’accompagnement (Younès, 2009) provenant d’un conseiller pédagogique, c’est-à-dire d’un professionnel de l’enseignement supérieur et de la pédagogie universitaire qui exerce le plus souvent dans un service de soutien à l’enseignement (Rege Colet, 2009), ou encore d’un pair. Mais encore faut-il que les questions posées aux étudiants permettent aux enseignants, comme aux professionnels de l’accompagnement, de s’inscrire dans une telle logique.

Depuis sa création en 2004 au sein de l’Université de Bourgogne (uB), le Centre d’innovation pédagogique et d’évaluation (CIPE) aspire à développer l’EEE, et à promouvoir et à accompagner le développement professionnel pédagogique des enseignants en proposant des formations et de l’accompagnement personnalisés. Pour ce faire, il a construit et mis en oeuvre un dispositif d’EEE depuis près de 10 ans. Cette étude propose une évaluation de celui-ci sous un angle non étudié à ce jour. En effet, elle ne s’intéressera ni aux questions classiques de validité (Detroz, 2008), ni à l’étude des avis des enseignants sur le dispositif (Bernard, Postiaux, & Salcin, 2000 ; Younès, 2007), ni aux effets de l’EEE sur les pratiques pédagogiques des enseignants (Rege Colet, 2002). En fait, cette analyse repose sur l’étude des apports des questions de l’EEE pour l’évaluation-conseil (Bedin, 2009) par le biais d’une analyse exploratoire des questions choisies par des équipes pédagogiques dans la construction de leurs dispositifs d’EEE. Cette recherche vient compléter une réflexion antérieure amorcée par les travaux de Berthiaume, Lanarès, Jacqmot, Winer et Rochat (2011) sur le positionnement de l’EEE. En effet, la comparaison du dispositif bourguignon avec ceux de l’Université catholique de Louvain (UCL), de l’Université de Lausanne (UNIL) et de l’Université McGill à Montréal, faite sur la base de l’étude des directives et des politiques des établissements ainsi que des pratiques d’EEE selon les principes de la confidentialité, de la responsabilité, de l’adaptabilité et de la réflexivité, a souligné la faiblesse du dispositif d’EEE du CIPE en matière de réflexivité, comparativement à d’autres dispositifs (Berthiaume, Jacqmot, Perret, & Rochat, 2011 ; Perret, 2010). Ce travail s’inscrit également dans le champ de la recherche de principes de développement pour un centre de soutien à l’enseignement qui souhaite asseoir ses actions d’après les savoirs issus de travaux scientifiques. Enfin, cette étude n’a pas seulement pour objectif de dresser un diagnostic des principales interrogations que se posent les enseignants. Elle cherche aussi à étudier si les questions peuvent permettre d’intégrer l’évaluation dans un cadre d’évaluation-conseil et, notamment, si les dimensions explorées dans les questionnaires relèvent des éléments modifiables par les enseignants. En d’autres termes, les questions qui sont posées aux étudiants dans le cadre des dispositifs de l’EEE sont-elles pertinentes pour soutenir la pratique réflexive des enseignants, telle que théorisée par Schön (1993) ?

Cet article est décliné en trois parties. La première présente le contexte de l’étude empirique en donnant de l’information sur les données utilisées dans cette recherche et sur ses choix méthodologiques. La deuxième s’attache à retranscrire les principaux résultats des travaux accompagnés de quelques hypothèses explicatives. Enfin, la conclusion conduit vers les perspectives de l’évaluation-conseil dans le cadre de l’EEE au sein de l’Université de Bourgogne.

Contexte

Les données de l’étude empirique

Concernant l’EEE, au sein de l’uB, université pluridisciplinaire de taille moyenne (26 500 étudiants,), le CIPE a d’abord travaillé avec des composantes, des formations, des diplômes et/ou des enseignants sur la base du volontariat. Dans ce cadre, le CIPE a proposé un accompagnement individualisé prenant en compte les besoins spécifiques de chacun afin de mettre en évidence les vertus et les utilités de l’EEE pour le fonctionnement de l’institution. Au terme de l’année universitaire 2008-2009, la quasi-totalité des composantes de l’uB s’est impliquée de manière progressive dans l’évaluation des enseignements. Forte de ce constat et pour faire face aux impératifs de l’Agence d’évaluation de la recherche et de l’enseignement supérieur (AERES), l’uB s’est engagée dans une généralisation de l’EEE : l’ensemble des licences généralistes de l’établissement, soit 36 formations, a participé à ce processus en 2009-2010. Conformément aux souhaits des directeurs de composantes, le CIPE a continué à travailler en étroite concertation avec chaque équipe pédagogique pour la mise en place de cette évaluation : détermination des objectifs, construction du questionnement, organisation de l’évaluation, traitement des questionnaires, mode de restitution et diffusion des résultats. Chaque enseignement (unité d’enseignement, module ou cours, etc.) a ainsi été évalué par les étudiants à partir de questionnaires (papier ou en ligne, semestriels ou annuels, avant ou pendant les examens).

Pour ses enseignements, chaque équipe pédagogique a conçu son questionnaire en collaboration avec le CIPE : toutes ont ainsi pu choisir les questions qu’elles souhaitaient poser à leurs étudiants concernant leurs enseignements. Pour ce faire, elles avaient la possibilité de créer leurs propres questions ou de choisir parmi une liste de 102 questions proposées par le CIPE. Ces dernières sont issues de questionnaires d’autres universités françaises ou étrangères ou encore de questionnaires proposés au cours des années précédentes au sein de l’établissement. Ces 102 questions relèvent de différents thèmes, mais ces derniers n’abordent pas l’intégralité des thèmes de questionnement généralement mis en avant pour l’évaluation des enseignements rappelés par Bernard (2011), soit la planification de l’enseignement, la prestation de l’enseignant, l’apprentissage réalisé par les étudiants et la connaissance de la matière, compte tenu du contexte français, où le développement de l’EEE peut se heurter à de fortes résistances. Ainsi, contrairement aux préconisations de Centra (1993), de King, Ambrose, Arreola et Watson (2009) et de Bernard (2011) dans le contexte nord-américain, aucune question sur la connaissance et sur la maîtrise de la matière enseignée par l’enseignant n’a été introduite. De même, les propositions de Marsh (1987) et de Feldman (1989) sur l’enthousiasme et/ou sur le dynamisme de l’enseignant ont été exclues pour parer aux critiques selon lesquelles l’EEE s’apparente à l’évaluation des « enseignants », sachant en outre qu’elles ne font pas l’objet d’une unanimité parmi les spécialistes et les chercheurs en évaluation des enseignements. Bernard (2011) énonce également des dimensions qu’elle estime inappropriées lors de l’EEE : pertinence des contenus et objectifs, conditions d’enseignement, respect des règles de bienséance par l’enseignant, maîtrise de la langue d’enseignement par l’enseignant et caractéristiques des étudiants. Bernard (2011) défend l’idée que d’introduire les caractéristiques des étudiants est majoritairement le fait d’enseignants opposés à l’EEE et qui souhaitent ainsi mettre en lumière l’incapacité des étudiants à évaluer les enseignements. Au sein de l’Université de Bourgogne, ces sujets n’ont pas été abordés, à l’exception des caractéristiques des étudiants, qui font l’objet de quelques questions (moins d’une dizaine) dans la liste fournie par le CIPE, car, contrairement à Bernard (2011), le CIPE considère que les questions sur ce sujet peuvent apporter de l’information utile à l’enseignant pour sa pratique réflexive.

Parmi les 36 formations de cette étude, 31 formations ont construit leur questionnaire en s’appuyant sur la liste fournie par le CIPE : une s’en est inspirée pour construire ses propres questions, tandis qu’une autre ne l’a pas utilisée. Précisons que trois formations ont utilisé un questionnaire préexistant : deux formations avaient déjà réalisé l’évaluation des enseignements avec le CIPE (leurs questions étaient intégrées dans la liste fournie par le CIPE) et une formation a réutilisé le questionnaire utilisé à l’interne et l’a construit sans l’appui du CIPE. Cette dernière formation a été exclue de la présente analyse parce qu’elle introduit une hétérogénéité faiblement représentée au sein des modalités de construction des questionnaires, ainsi que la formation ayant choisi des questions différentes d’un enseignement à l’autre. Au final, les questionnaires de 34 formations de l’uB ont été utilisés. Ces 34 formations se répartissent de la manière suivante : 35 % relèvent des sciences-technologies-STAPS[4], 29 % du domaine des arts-lettres-langues, 24 % des sciences humaines et sociales, et 12 % du domaine droit-économie-gestion. Les questionnaires ont été établis pour des promotions variant de 4 à 333 étudiants.

Les choix méthodologiques pour l’étude des questionnaires

De multiples sources d’information sont recommandées pour évaluer un enseignement (Bernard, 2011) et, donc, pour produire des savoirs susceptibles d’être mobilisés par l’enseignant. Les questionnaires auprès des étudiants, qui permettent de recueillir leurs opinions et leurs points de vue, ne sont qu’un des moyens possibles. D’autres sources d’information, telles que les comités d’enseignement ou des conseillers pédagogiques, peuvent également apporter des éléments, par exemple par le biais d’une analyse du matériel pédagogique, du dossier d’enseignement ou encore de l’observation directe en cours. Précisons que ces pratiques sont très peu utilisées en France, à l’exception des universités où un centre de pédagogie dédié au soutien à l’enseignement (tel que le CIPE à l’uB) le propose. Bien sûr, l’enseignant lui-même peut faire une analyse réflexive de ses enseignements.

Parmi les principes d’amélioration des pratiques d’évaluation des enseignements figure la nécessité d’un processus évolutif qui lie l’évaluation, l’amélioration et la valorisation de l’enseignement (Bernard, 2011). Le caractère formatif de l’EEE est généralement illustré par le fait qu’il apporte de l’information sur les pratiques enseignantes, eu égard à un certain nombre de critères qui établissent un enseignement « efficace » : la planification et l’organisation des cours et l’évaluation des apprentissages (Bernard, 2011). L’amélioration des enseignements repose alors sur des changements permettant de tendre vers des indicateurs (au sens large) d’efficacité plus élevés. Le critère d’efficacité est alors valorisé. Mais, avant de s’intéresser à l’efficacité, il est nécessaire de prendre en compte l’utilité.

Dans cette recherche, l’hypothèse posée est que la nature de l’information fournie aux enseignants a son importance dans le processus réflexif : certaines informations pouvant donner lieu à des actions plus directement réalisables par l’enseignant, et dont les effets sont sans doute plus directement mesurables. Cette recherche concerne donc l’un des niveaux de l’analyse réflexive développée par les enseignants sur leurs actions, c’est-à-dire la réflexion sur l’action (après) et non la réflexion dans l’action (pendant) selon les définitions de Schön (1993). Elle s’intègre ainsi dans l’une des étapes de production des savoirs par les enseignants, qui après l’analyse d’informations, procèdent soit par exploration (essais-erreurs), par expérimentation (qu’arriverait-il si... ?) ou par vérification d’hypothèses. Ici, les informations sont données par les résultats de l’EEE sur une action passée, et ces informations analysées par les enseignants permettent de s’engager dans une nouvelle forme d’action si l’enseignant le juge nécessaire.

Ce positionnement permet de renouveler l’analyse possible des dispositifs d’EEE en examinant si les questionnaires donnent des informations utiles pour la réflexivité des enseignants, laquelle s’inscrit dans un continuum allant de la réflexion jusqu’à l’action. Dans cette perspective, les questionnaires conçus par les équipes pédagogiques sont étudiés de manière exploratoire en utilisant une grille permettant de répartir les questions dans trois principales catégories :

celles qui relèvent de l’enseignant (sur lesquelles l’enseignant peut agir) ; cette première thématique est appelée « actions possibles de l’enseignant » ;

celles qui relèvent plutôt de l’étudiant (sur lesquelles celui-ci peut agir), sachant cependant qu’il est aussi possible qu’une action de l’enseignant ou de l’organisation puisse avoir un impact dans cette catégorie ; cette thématique est nommée « actions et/ou caractéristiques de l’étudiant » ;

celles qui relèvent plutôt de l’organisation générale de la formation ou du cursus.

Les deux premières catégories sont détaillées par grands thèmes. Ainsi, concernant les « actions possibles des enseignants » sont distinguées des questions ayant trait au contenu de l’enseignement, au matériel pédagogique, à l’organisation et modalités pédagogiques du cours, à l’interaction enseignant-étudiant, aux aspects d’évaluation et rétroaction, et à la charge de travail. Ici un thème général a également été retenu pour des questions abordant ces thèmes de manière très large. Pour ce qui touche les « actions et/ou caractéristiques de l’étudiant », des questions relatives au travail des étudiants, à leur intérêt, motivation et implication, à leurs projets professionnels et/ou de formation, à leur satisfaction et à leurs difficultés ont été isolées. Pour ce qui est des aspects relevant de l’organisation générale de la formation ou du cursus, trois thèmes ont été identifiés après une première lecture des questionnaires : la place du cours dans le cursus, le temps consacré à la matière et une catégorie « autre ». D’autres types de questions ont également été identifiés sans être associés à une des trois grandes catégories présentées ci-dessus : les questions relatives aux prérequis, les questions ouvertes destinées à recueillir les suggestions et les remarques des étudiants, et les questions qui ne peuvent être classifiées dans les catégories précédentes. Cela permet la création d’un fichier d’analyse comportant différentes variables pour chaque formation : au total, 23 variables ont été codées sous la forme de données numériques (nombre de questions relevant de la catégorie), auxquelles sont rajoutés le secteur disciplinaire et les effectifs étudiants, le nombre total de questions par enseignement, le fait que les équipes aient utilisé la liste préétablie par le CIPE et le fait qu’elles aient conçu leurs propres questions, ainsi qu’un code d’identification de la formation. Au final, le fichier comprend 29 variables.

Résultats

Les premiers résultats

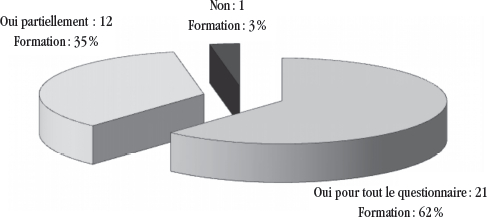

Les équipes pédagogiques avaient plusieurs recommandations pour la construction des questionnaires d’EEE : choisir des questions identiques pour chaque enseignement au sein d’une formation et se limiter à une douzaine de questions par enseignement. Dans l’échantillon, le nombre moyen de questions est de 13,5, mais ce nombre est très variable selon les formations (écart-type = 4,3), allant de 5 à 25. Douze formations ont choisi d’inclure plus de 12 questions, soit 35 % des formations. Faut-il déceler dans ce dépassement des recommandations une forte envie de connaître les opinions étudiantes ou les conséquences de la stratégie d’implantation de l’EEE au sein de l’établissement ? En effet, le CIPE accompagne les équipes pédagogiques en leur offrant un appui méthodologique et logistique, mais il n’a pas comme vocation de dicter ou de contrarier leurs choix, sauf lorsque des questions s’intéressent à connaître des dimensions relatives à la personnalité de l’enseignant (son caractère, par exemple). Par ailleurs, il n’existe pas de lien entre le nombre de questions choisies pour l’EEE et la taille des promotions étudiantes (coefficient de corrélation non significatif : r = 0,053, t = 0,30). De même, la taille moyenne des questionnaires n’est pas différente d’un domaine de formation à un autre. Les équipes se sont largement appuyées sur les propositions du CIPE pour construire leur EEE (voir graphique 1). La taille moyenne des questionnaires n’est pas différente selon que les équipes pédagogiques ont utilisé exclusivement ou non la liste des questions fournies par le CIPE.

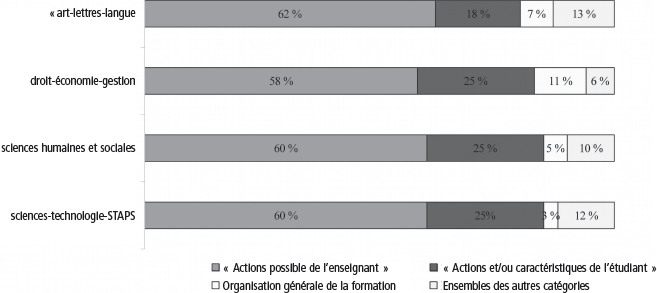

Pour l’ensemble des formations, le nombre moyen de questions s’élève à 13,6. Le questionnaire est décomposé en moyenne en (voir figure 2) :

8,4 questions relatives aux « actions possibles de l’enseignant », soit 60 % du questionnaire ;

3,1 questions concernant les « actions et/ou caractéristiques de l’étudiant », soit 23 % du questionnaire ;

0,6 question sur l’organisation générale de la formation ou du cursus, soit 5 % du questionnaire ;

et 1,4 question portant sur d’autres aspects, soit 11 % du questionnaire.

Figure 1

Utilisation des questions fournies par le CIPE pour la construction du questionnaire de l’EEE

D’ores et déjà, la part des questions qui permettent d’obtenir des savoirs liés à des points où l’enseignant pourra directement agir est très importante. La répartition adoptée par les équipes enseignantes est ainsi largement en adéquation avec la liste des 102 propositions émises par le CIPE pour aider à construire les questionnaires, qui comportent 74 % de questions relatives aux « actions possibles de l’enseignant », 19 % concernant les « actions et/ou caractéristiques de l’étudiant », 5 % portant sur l’organisation générale de la formation ou du cursus et 2 % sur d’autres aspects. Cependant, dans les choix des équipes, la part des « actions possibles de l’enseignant » apparaît plus faible que dans les propositions du CIPE (60 % contre 74 % dans les propositions du CIPE) au profit des questions sur les « actions et/ou caractéristiques de l’étudiant » (23 % contre 19 %). Sans nier les effets des propositions émises par le CIPE, faut-il y voir un effet des oppositions des enseignants à l’EEE à cette plus forte importance des « actions et/ou caractéristiques de l’étudiant », comme le propose Bernard (2011) ?

Figure 2

Composition moyenne des questionnaires d’EEE

Compte tenu du fait que le nombre de questions choisies dans les questionnaires d’EEE varie selon les formations, il est nécessaire de recourir à une analyse permettant de réduire les effets liés à la taille. Nous raisonnons donc en parts relatives de chaque catégorie par rapport au nombre total de questions dans un questionnaire. Le tableau des proportions moyennes des différentes catégories des questionnaires d’EEE permet de mettre en évidence leurs poids respectifs (voir tableau 1). Les questions relatives aux « actions possibles de l’enseignant » représentent en moyenne 60 % des questionnaires d’EEE. Parmi ces dernières, les questions concernant l’organisation et les modalités pédagogiques ont une place très importante puisqu’elles représentent plus du quart des questions posées (26 %, exactement). Ce type de questions est ainsi plus important que celles ayant trait aux « actions et/ou caractéristiques de l’étudiant ». Les principales préoccupations des équipes pédagogiques sont ainsi tournées vers des aspects de l’enseignement. Viennent ensuite trois autres dimensions : le contenu de l’enseignement, des questionnements sur l’évaluation, et la rétroaction et le travail des étudiants.

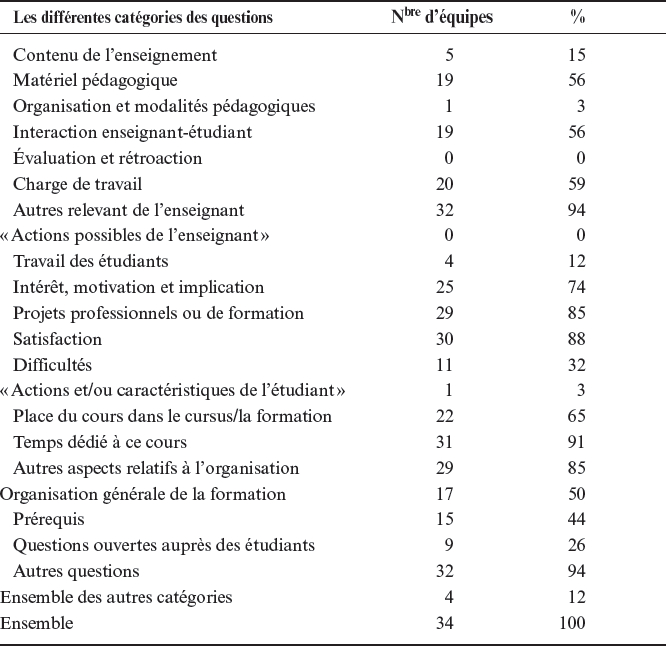

Tableau 1

Poids moyens des différents types de questions de l’EEE

Dans la mesure où la quasi-totalité des équipes pédagogiques ont conçu leurs questionnaires en s’appuyant sur les propositions du CIPE, il est impossible d’étudier les effets du non-recours au CIPE. Le poids des quatre grandes catégories est peu différent d’un domaine à un autre (voir figure 3). Nous pouvons tout juste mettre en évidence que les questions relatives aux « actions et/ou caractéristiques de l’étudiant » sont légèrement moins importantes en arts-lettres-langues, en raison de la faible présence de questions relatives au travail des étudiants (7 % des questionnaires dans ces disciplines contre plus de 15 % en sciences humaines et sociales et en droit-économie-gestion). Un examen approfondi du poids des thèmes composant ces différentes catégories ne permet pas de mettre en évidence des différences significatives selon les domaines de formation.

Figure 3

Poids moyen des différentes catégories de questions selon les domaines de formation

Par ailleurs, l’analyse de la proportion de chacune des catégories de questionnements ne met pas en évidence un lien entre la nature des questions choisies par les équipes pédagogiques et la taille du questionnaire d’EEE (nombre total de questions). En revanche, il existe des corrélations significatives entre la taille des promotions étudiantes et la nature des questionnements : le poids des questions relatives aux projets des étudiants est d’autant plus important que la promotion est grande et le poids de « l’ensemble des autres catégories » est moins fort pour des grandes promotions. L’analyse de la matrice des corrélations permet également de mettre en évidence d’autres aspects sur les questionnaires d’EEE. Le principal est le suivant : plus le poids des questions relatives au contenu est fort, moins les questions concernant les projets professionnels ou de formation des étudiants (r = 0,342; t = -2,06) ou leurs difficultés (r = 0,474; t = -3,05) représentent une partie importante des questionnaires d’EEE. En fait, plus les questionnaires sont tournés vers des aspects relatifs au contenu de l’enseignement, moins les questions s’intéressent d’une manière générale aux aspects liés aux étudiants (r = -0,471; t = -3,02) et comportent une question ouverte pour recueillir les opinions et les suggestions des étudiants (r = -0,388, t = -2,38). En outre, il existe une corrélation positive et significative entre le poids des questionnements sur les difficultés des étudiants et celui relatif aux interrogations sur les projets professionnels ou de formation des étudiants (r = 0,589; t = 4,12).

Les cartographies de l’EEE

Devant ces résultats, il est difficile de poursuivre l’analyse du poids des différentes catégories pour chaque formation et pour l’ensemble des formations afin d’obtenir différentes cartographies des questions utilisées par les équipes pédagogiques pour l’EEE, compte tenu de la faible diversité des choix des formations. Les choix des équipes sont désormais étudiés en s’intéressant au fait que les équipes ont pris en compte ou non les différents thèmes (voir tableau 2). Dans cette optique, l’analyse des corrélations entre toutes les différentes catégories se révèle impraticable, compte tenu des effectifs. Une analyse factorielle est également peu pertinente. Nous pouvons, en revanche, étudier le nombre d’équipes ayant choisi ou non les différents thèmes et faire ressortir les possibles particularités d’équipes pédagogiques ainsi différenciées.

Tableau 2

Les thèmes exclus par les équipes pédagogiques

La catégorie « actions possibles de l’enseignant »

Il ressort ainsi qu’aucune formation ne s’est dispensée de questions ayant trait aux actions possibles de l’enseignant. Les aspects les plus largement pris en compte sont ceux relatifs à l’évaluation et à la rétroaction, à l’organisation et aux modalités pédagogiques, et, enfin, au contenu de l’enseignement.

Le contenu de l’enseignement

Seules cinq équipes pédagogiques n’ont pas posé de questions relatives au contenu de l’enseignement. Ces cinq équipes appartiennent à deux domaines de formation : quatre des sciences-technologies-STAPS et une des sciences humaines et sociales. Ce sont des formations aux effectifs compris entre 40 et 75 étudiants pour celles des sciences-technologies-STAPS et de moins de 20 étudiants pour celles de sciences humaines et sociales. Elles s’appuient sur la liste fournie par le CIPE pour construire leur questionnaire. Les équipes des sciences-technologies-STAPS se distinguent par le faible nombre de questions (huit ou neuf contre 14 en moyenne). Ce premier résultat peut constituer une surprise : en effet, le monde universitaire considère très souvent que les étudiants ne sont pas aptes à émettre un avis sur le contenu de l’enseignement. Pourtant, ici, la grande majorité des équipes a questionné les étudiants sur ce sujet.

Le matériel pédagogique

Plus de la moitié des équipes n’ont pas posé de questions sur le matériel pédagogique. Ce sont des équipes appartenant à tous les domaines de formation ayant construit des questionnaires d’EEE courts ou longs pour des promotions aux effectifs variés. Ce sont proportionnellement plus souvent des équipes des sciences-technologies-STAPS (42 % contre 35 % en moyenne. La question du matériel pédagogique est plutôt peu abordée dans les questionnaires. Quelques hypothèses pourraient peut-être être avancées pour l’expliquer : le modèle d’enseignement universitaire, plutôt traditionnel, qui n’envisage pas ou peu de changements dans les matériaux utilisés pour l’enseignement ; la prégnance de certains outils sur lesquels on ne revient plus (diaporama par exemple) ; la difficulté à utiliser de nouveaux matériels dont on ne connaît pas les effets pédagogiques (positifs ou négatifs) ; l’obligation d’un certain matériel pédagogique en fonction de la discipline, etc.

L’organisation et les modalités pédagogiques

Seule une formation n’a pas posé de questions relatives à l’organisation et aux modalités pédagogiques de l’enseignement. Cette formation du domaine arts-lettres-langues a peu d’étudiants et a posé peu de questions dans son questionnaire d’EEE (5 au total) sans recourir à l’aide du CIPE.

Les interactions enseignant-étudiant

Comme pour le matériel pédagogique, plus de la moitié des équipes n’a pas posé de questions à propos des interactions enseignant-étudiant. La majorité d’entre elles (10 sur les 19 concernées) appartiennent au domaine des sciences-technologies-STAPS (52 % contre 35 % en moyenne). Toutes les formations de plus de 120 étudiants n’ont pas posé de questions concernant ce thème. Signalons qu’une partie des formations aux effectifs réduits a également choisi de ne pas interroger les étudiants sur ce thème. L’examen de ces interactions se révèle également moins important lorsque les équipes ont produit un questionnaire d’EEE réduit (moins de neuf questions) : seule une formation sur les huit ayant produit ce type de grille d’EEE interroge les étudiants sur ce thème contre plus de la moitié des formations ayant produit des grilles plus longues (56 %, exactement). Les recherches en psychologie cognitive des quelque 40 dernières années ont montré que la transmission d’informations ne suffisait pas pour construire les apprentissages, plus encore des apprentissages en profondeur. À l’inverse de ce modèle dit « transmissif », nombre de théories actuelles de l’apprentissage, qui s’inscrivent dans les courants constructivistes et socioconstructivistes, considèrent que, pour construire son propre savoir, l’étudiant doit participer activement et interagir avec les autres, et proposent des méthodes pédagogiques dites « actives ». Pourtant, les enseignants éprouvent encore parfois des difficultés à s’engager dans une interaction enseignant-étudiant durant les cours. Diverses raisons sont souvent avancées : citons par exemple le format habituel du cours magistral et la taille des groupes, mais aussi le fait que nombre d’enseignants-chercheurs n’imaginent pas s’affranchir du modèle traditionnel d’enseignement magistral qui, il faut le noter, leur a le plus souvent convenu lorsqu’ils étaient étudiants.

L’évaluation et la rétroaction

Toutes les équipes pédagogiques ont interrogé les étudiants sur l’évaluation et la rétroaction.

La charge de travail

Près de six équipes sur 10 n’ont pas interrogé les étudiants sur la charge de travail liée à l’enseignement. Aucune spécificité n’a été relevée. Les équipes ayant produit les questionnaires avec le plus grand nombre de questions (plus de 15) intègrent plus souvent ce type de questions dans l’EEE : 67 % d’entre elles contre 27 % des autres équipes. Les équipes interrogeant les étudiants sur la charge de travail liée à un enseignement ne les questionnent jamais sur leurs projets professionnels ou de formation. Il existe une corrélation entre le fait d’introduire des questions sur la charge de travail et sur les interactions enseignant-étudiant. Ainsi, 64 % des équipes s’intéressant à la charge de travail des étudiants questionnent également les étudiants sur les interactions enseignant-étudiant contre 30 % des autres équipes.

La catégorie « actions et/ou caractéristiques de l’étudiant »

Concernant plus précisément les différents thèmes relatifs aux « actions et/ou caractéristiques de l’étudiant », ils sont soit très majoritairement, soit très minoritairement pris en compte par les équipes pédagogiques. C’est principalement le travail des étudiants qui est l’objet des questions des équipes pédagogiques. Seules quatre équipes (dont aucune du domaine droit-économie-gestion) ne se sont pas intéressées à cette question. Vient ensuite celle des difficultés des étudiants : 11 équipes ne s’y intéressent pas dans leur questionnaire d’EEE. Ces équipes appartiennent à tous les domaines de formation de l’établissement, à l’exception du domaine arts-lettres-langues. Lorsque les équipes pédagogiques ne s’intéressent pas aux difficultés des étudiants, elles ne s’intéressent également pas à leurs projets professionnels ou de formation.

Par ailleurs, les aspects concernant la satisfaction des étudiants ainsi que l’intérêt, la motivation et l’implication des étudiants, comme leurs projets professionnels et/ou de formation, sont pris en compte par un très faible nombre d’équipes pédagogiques. En effet, seules quatre équipes ont posé des questions relatives à la satisfaction des étudiants concernant les enseignements dispensés. Ce sont de petites formations (la question n’est jamais posée pour les formations aux effectifs importants). Aussi, 74 % des équipes ne cherchent pas à questionner les étudiants sur des aspects relatifs à leur intérêt, à leur motivation ou encore à leur implication dans leurs études. Les équipes interrogeant les étudiants sur ces aspects appartiennent à tous les domaines, bien que les équipes de sciences-technologies-STAPS soient surreprésentées (55 % contre 35 % en moyenne). Des formations aux effectifs réduits ou importants posent de telles questions aux étudiants. Nous pouvons toutefois relever que les équipes ayant produit les questionnaires avec le plus grand nombre de questions (plus de 15) intègrent plus souvent ce type de questions dans l’EEE : 50 % d’entre elles contre 14 % des autres équipes. Enfin, 85 % des équipes ne s’intéressent pas aux projets professionnels ou de formation des étudiants dans les questionnaires d’EEE. Les cinq équipes ayant un intérêt pour ces aspects appartiennent à deux facultés : les STAPS et le droit. Ces formations ont des effectifs de plus de 45 étudiants par année.

Les questions relatives aux « actions et/ou caractéristiques de l’étudiant » sont souvent d’une grande diversité et s’intéressent avec acuité à leur intérêt pour l’évaluation formative en général et pour l’évaluation-conseil en particulier. En effet, si on veut aller au-delà de l’évaluation qui dresse un constat et entrer dans une démarche réflexive, peut-on utiliser des données produites par ces questions ? Dans cette catégorie, nous distinguons au moins deux types de questionnements qui semblent avoir un intérêt dans le cadre de l’évaluation-conseil. Le premier paraît s’intéresser plutôt au ressenti des étudiants (leur satisfaction, leur intérêt et leur motivation), tandis que le second concerne plutôt leurs expériences d’apprentissage (le travail et les difficultés des étudiants). À propos de la première catégorie, les résultats peuvent apparaître de prime abord comme peu exploitables par l’enseignant : l’intérêt et la motivation pourraient sembler être des dimensions très personnelles de l’étudiant sur lesquelles l’enseignant n’a que peu de prise. Pourtant, les travaux de Wigfield et Eccles (2000) (expectancy-value theory) sur le phénomène complexe qu’est la dynamique motivationnelle, ont mis en lumière que celle-ci est constituée de deux variables : la perception de sa compétence qu’a l’apprenant et la valeur qu’il accorde à la tâche ; et que cette dynamique motivationnelle n’est pas figée et se reconfigure. Ce qui plaide en faveur de l’avantage pour les enseignants de récolter ce type de données et d’en faire usage, par exemple en clarifiant le sens et l’utilité de la matière de leur cours. De même, des données à propos du travail ou des difficultés exprimées par les étudiants sont d’un intérêt certain. À propos du travail des étudiants, nombre de questions paraissent pertinentes pour, par exemple, réorganiser les travaux des étudiants ou les informer de la charge de travail qui est nécessaire dans le cours. Cependant, l’intérêt d’une question comme « Travaillez-vous assez pour réussir votre licence ? » introduite par une formation paraît discutable au regard des impacts possibles de l’EEE sur les pratiques pédagogiques des enseignants. Que peut en effet tirer l’enseignant des réponses à ce genre de question pour modifier ses pratiques ? Quelles que soient les données récoltées, elles ne peuvent pas être utiles à l’enseignant dans le cadre de sa pratique réflexive, car ne sont-elles pas même contreproductives pour l’enseignant en l’incitant à renvoyer la responsabilité de l’apprentissage aux seuls étudiants ? Ce constat renvoie également à la problématique du positionnement du CIPE qui peut difficilement s’opposer aux choix des équipes pédagogiques dans un contexte où l’EEE n’est pas largement acceptée.

La catégorie « organisation générale »

La moitié des formations ont posé des questions relatives à l’organisation générale de la formation (en dehors de toute action de l’enseignant ou de l’étudiant). Si celles-ci peuvent de prime abord apparaître comme peu utiles pour l’enseignant, car elles pourraient se situer au-delà de son champ possible d’intervention, il faut cependant nuancer cette impression. En effet, n’est-il pas intéressant pour l’enseignant de connaître les perceptions des étudiants vis-à-vis de la formation dans sa globalité ? Qui plus est, l’enseignant s’inscrit dans une équipe pédagogique au sein d’une formation. Si on envisage, par exemple, que se développe de plus en plus une approche-programme au sein des filières de formation, ces données présentent un intérêt certain. Les questions relatives à la place du cours sont notamment plus fréquemment posées par les formations dont les effectifs étudiants sont importants : 60 % des formations ayant au moins 90 étudiants contre 35 % en moyenne. Toutes les formations du domaine droit-économie-gestion posent ce type de questions.

Les questions ouvertes

Seulement neuf formations (soit le quart) n’ont pas souhaité introduire une question ouverte. Ces formations appartiennent à tous les domaines, ont produit des questionnaires de tailles variables et ont des promotions d’étudiants de tailles diverses. Elles se singularisent des autres formations par le fait qu’elles ont toutes pris en compte des questions sur le contenu de l’enseignement et que 44 % des équipes pédagogiques n’ont pas posé de questions sur les prérequis des étudiants (soit 15 équipes). Il existe des différences notables entre les équipes ayant choisi ou non de poser ce type de questions à leurs étudiants. Ainsi, les formations aux effectifs réduits (moins de 33 étudiants) interrogent plus fréquemment leurs étudiants à ce sujet (87 % contre 56 % en moyenne). Seulement 25 % des formations des sciences humaines et sociales prennent en compte cette dimension dans leur questionnaire d’EEE contre plus de 80 % des formations du domaine arts-lettres-langues. Toutes les formations s’intéressant aux prérequis de leurs étudiants dans les questionnaires d’EEE interrogent également ces derniers à propos de leurs projets professionnels ou de formation. Enfin, seules quatre formations n’ont pas posé de questions relatives à d’autres aspects.

Discussion et conclusion

Les résultats de cette recherche permettent de dresser un diagnostic sur la nature des questionnements des équipes pédagogiques concernant leurs enseignements. Ceux-ci sont variés, mais une part non négligeable d’entre eux peut être profitable dans le cadre de l’évaluation-conseil en fournissant aux enseignants des informations réellement utiles pour conforter ou pour modifier leurs enseignements. C’est le cas évidemment des questions catégorisées en tant qu’ »actions possibles de l’enseignant », où les questions liées au contenu de l’enseignement, à l’organisation et aux modalités pédagogiques, et à l’évaluation des apprentissages permettent aux enseignants, dans un premier temps, d’obtenir des résultats exploitables pour conforter ou pour modifier leurs enseignements. À l’inverse, des pans entiers sont négligés : le matériel pédagogique, mais aussi – et peut-être surtout – des questions principalement liées aux étudiants, qu’il s’agisse de mieux les connaître, de savoir quelles sont leurs difficultés et leur charge de travail ou d’envisager les interactions qui pourraient être construites avec eux. Ce qui pose la question de la prise en compte de l’apprenant comme un acteur à part entière du processus enseignement-apprentissage, dans un « triangle pédagogique » tel que défini par Houssaye (1988) dans son modèle de compréhension du processus. Les résultats de cette recherche montrent cependant que les quelques équipes qui questionnent sur la charge de travail étudiante sont également celles qui interrogent sur les interactions étudiant-enseignant. On pourrait donc faire l’hypothèse que la prise en compte des étudiants est une étape qui conduit vers une autre étape qui serait l’interaction, soit un second pas vers des méthodes actives en pédagogie. Pour les autres équipes, le manque de prise en compte des étudiants doit-il être corrélé avec des conceptions de l’enseignement davantage magistro-centrées que pédo-centrées (Frenay, 2006) renvoyant à d’autres constats établis par de jeunes assistants de l’uB (Demougeot-Lebel & Perret, 2011a), qui avaient en majorité des conceptions de l’enseignement magistro-centrées avant leur participation à une formation pédagogique ?

En soulignant l’absence de recueil de données en lien avec certaines dimensions de la relation pédagogique (notamment les difficultés étudiantes et les interactions enseignant-étudiant), ce travail poursuit le questionnement sur la perception de l’étudiant chez les enseignants-chercheurs en France.

D’autres résultats ne sont pas à négliger, compte tenu de leur caractère informatif sur l’EEE. L’absence de liens entre la nature des questions posées et la longueur des questionnaires ne permet pas de dégager une hiérarchie des préoccupations des équipes enseignantes en matière d’enseignement. Il apparaît seulement que les questionnaires les plus longs intègrent plus souvent des questions relatives à la satisfaction des étudiants, à leur intérêt, à leur motivation et à leur implication dans la formation, par exemple leurs projets professionnels, comme si ces aspects de l’apprentissage des étudiants n’apparaissaient pas prégnants aux yeux des enseignants. Une hypothèse à poser ici serait que, dans un cadre contraint par le nombre de questions, les enseignants-chercheurs font le choix de s’intéresser d’abord à ce qu’ils peuvent modifier, ce qui paraît donc bien aller dans le sens d’une vraie pratique réflexive. Pourtant, cela paraît aussi révéler une méconnaissance des divers savoirs qui peuvent nourrir la pratique réflexive, c’est-à-dire les savoirs qui portent sur autrui ou sur les éléments organisationnels ou contextuels.

De même, la nature des questionnements n’est pas marquée par des différences entre les secteurs disciplinaires ou selon la taille des promotions étudiantes. Tout au plus, l’absence de questions sur les interactions enseignant-étudiant est plus fréquente dans les secteurs scientifiques et elle tend à être plus souvent associée à des recherches d’information sur la charge de travail des étudiants. Ce sont en outre plus souvent les équipes pédagogiques confrontées à des promotions importantes qui questionnent sur les projets des étudiants, ces types de questions étant eux-mêmes plus fréquemment associés à celles relatives aux difficultés éprouvées par les étudiants, et non à des recherches d’information sur les motivations, les intérêts et l’implication des étudiants dans leur formation. Ce résultat démontre sans doute les effets d’une plus grande méconnaissance du public étudiant par les enseignants liée à l’anonymat des grands amphithéâtres, qui sont le plus souvent la règle pour nombre de cours magistraux au sein des promotions étudiantes importantes en France, ces conditions d’enseignements étant vécues par les enseignants comme plus difficiles pour les étudiants. Connaître ces difficultés devient alors plus important aux yeux des enseignants que d’avoir des informations d’une autre nature.

Les résultats de cette étude invitent à réfléchir sur les aménagements possibles des dispositifs d’EEE existants à l’Université de Bourgogne, l’objectif étant d’affirmer la dimension formative de l’EEE pour les enseignants afin de permettre une meilleure mise en place de l’évaluation-conseil. L’absence de spécificités des équipes pédagogiques peut être un argument pour renoncer partiellement à l’accompagnement personnalisé généralisé, tel qu’il est actuellement mené au sein du CIPE pour les évaluations systématiques et obligatoires (votées annuellement par le conseil d’administration de l’établissement). Cet accompagnement personnalisé reste toutefois réservé aux formations ayant une démarche d’EEE spécifique et volontaire. En effet, dans le cadre des évaluations systématiques et obligatoires, la volonté institutionnelle d’un accompagnement individualisé des équipes pédagogiques a initialement été proposée par le CIPE afin de favoriser l’implantation de l’EEE en coupant court à une partie des oppositions recensées lors d’un état des lieux sur l’échec de l’EEE dans l’établissement avant la création du CIPE, les spécificités disciplinaires ou organisationnelles des différentes composantes de cette université pluridisciplinaire étant très souvent mises en avant par les responsables de formation. Il est peut-être temps pour le CIPE d’être plus prescriptif dans les conditions de réalisation de l’EEE pour favoriser l’émergence de thèmes et de questions dans les questionnaires plus utiles pour l’évaluation-conseil ainsi que pour favoriser le développement professionnel des enseignants de l’établissement. Ce choix permettrait également de proposer des pistes de réflexion pour accompagner le développement professionnel des enseignants en matière de formations et de conseils pédagogiques personnalisés, en les appuyant sur des analyses des besoins exprimés à travers les questionnements de l’EEE. En effet, dans toute démarche d’ingénierie de formation, les besoins identifiés permettent d’orienter les actions et, plus globalement, la politique de développement. Mais, comme il a été relevé dans un travail préalable, la difficulté à cibler les besoins par des méthodes habituelles existe (Demougeot-Lebel & Perret, 2011b). Les questionnements de l’EE pourraient apporter indirectement des renseignements sur ceux-ci. Toutefois, l’EEE est-elle suffisamment implantée et acceptée au sein de l’Université de Bourgogne, et par les équipes et les enseignants-chercheurs pour entrer dans cette phase de prescription sans mettre à mal l’EEE au sein de l’uB ? En effet, la pertinence de l’utilisation de l’EEE pour l’évaluation-conseil repose sur deux dimensions importantes : la participation des étudiants et l’utilisation des résultats par les enseignants. Or, ces deux aspects sont étroitement liés à l’adhésion des équipes enseignantes au processus d’évaluation mis en place par le CIPE.

En conclusion, cette étude participe aussi à intriquer plus fortement encore les deux axes du CIPE : l’évaluation des enseignements et l’accompagnement pédagogique, dans la mesure où ces deux axes se nourrissent de leurs activités réciproques. Reste qu’au-delà de la nature des questionnements, d’autres conditions concernant l’EEE sont nécessaires pour favoriser l’émergence de l’évaluation-conseil, ne serait-ce, par exemple, qu’une participation satisfaisante des étudiants pour assurer la validité et la pertinence des informations recueillies auprès des étudiants (Detroz, 2008).

Appendices

Notes

-

[1]

Communiqué du 1er septembre 2009 consulté à l’adresse suivante : http://www.snesup.fr/Presse-et-documentation?cid=3716&ptid=5&aid=4286.

-

[2]

50 revendications des étudiants pour la réussite de tous à l’université. Proposition n° 23 : « Formation des enseignants à la pédagogie, prise en compte de l’investissement pédagogique dans les carrières et évaluation des enseignements par les étudiants », site de l’UNEF consulté à l’adresse suivante : http://unef-cergy.over-blog.com/54-index.html.

-

[3]

Article 7-1. Décret n° 2009-460 du 23 avril 2009 modifiant le décret n° 84-43. du 6 juin 1984 fixant les dispositions statutaires communes applicables aux enseignants-chercheurs et portant statut particulier du corps des professeurs des universités et du corps des maîtres de conférences et portant diverses dispositions relatives aux enseignants-chercheurs.

-

[4]

STAPS : sciences et techniques des activités physiques et sportives.

Références

- Bedin, V. (2009). L’évaluation à l’université : évaluer ou conseiller ? Rennes, France : Presses universitaires de Rennes.

- Bernard, H. (2011). Comment évaluer, améliorer, valoriser l’enseignement supérieur ? Bruxelles, Belgique : De Boeck.

- Bernard, H., Postiaux, N., & Salcin, A. (2000). Les paradoxes de l’évaluation de l’enseignement universitaire. Revue des sciences de l’éducation, 26(3), 625-650.

- Berthiaume, D., Jacqmot, C., Perret, C., & Rochat, J. (2011, janvier). Comparaison de trois systèmes d’évaluation des enseignements par les étudiants et leurs effets sur le développement professionnel des enseignants. Présenté au 23e colloque international de l’ADMÉE-Europe Évaluation et enseignement supérieur, Paris, France.

- Berthiaume, D., Lanarès, J., Jacqmot, C., Winer, L., & Rochat, J. M., (2011). « L’évaluation des enseignements par les étudiants (EEE) ». Recherche et formation, 67, 53-72.

- Centra, J. A. (1993). Reflexive Faculty Evaluation. Enhancing Teaching and Determining Faculty Effectiveness. San Francisco, CA: Jossez-Bass.

- Comité de suivi de la licence (2011). Synthèse de l’enquête sur le fonctionnement de la licence. Extrait de http://www.lors.fr/uploads/DOCS/4634_resultats_enqlicence.pdf.

- Cour des comptes (2012). Rapport public annuel 2012. Extrait de http://www.ccomptes.fr/fr/CC/Sommaire-27.html.

- Dejean, J. (2002). L’évaluation de l’enseignement dans les universités françaises. Rapport établi à la demande du Haut Conseil de l’évaluation de l’école. Paris, France : Haut Conseil de l’évaluation de l’école.

- Demougeot-Lebel, J., & Perret, C. (2011a). Une formation pédagogique peut-elle modifier les conceptions de jeunes enseignants universitaires sur l’apprentissage et l’enseignement ? Revue des sciences de l’éducation, 37(2), 327-354.

- Demougeot-Lebel, J., & Perret, C. (2011b). Qu’attendent les enseignants universitaires français en termes de formation et d’accompagnement pédagogiques ?, Revue internationale de pédagogie de l’enseignement supérieur, 27(1). Extrait de http://ripes.revues.org/456.

- Detroz, P. (2008). L’évaluation des enseignements par les étudiants : état de la recherche et perspectives. Revue française de pédagogie, 165, 117-135.

- Douady, J. (Mars 2012). Le réseau des SUP, ses objectifs et ses travaux. Présentation à l’ESEN, Chasseneuil, France.

- Espéret, E. (2001). Nouvelle définition des tâches des enseignants et des enseignants-chercheurs dans l’enseignement supérieur français. Paris, France : Ministère de l’Éducation nationale.

- Faure S., Soulié, C., & Millet, M. (2005). Enquête exploratoire sur le travail des enseignants-chercheurs. Vers un bouleversement de la table des valeurs académiques ? Extrait de www.univ-paris8.fr/sociologie/fichiers/soulie2005a.pdf.

- Feldman, K. A. (1989). The association between student ratings of specific instructional dimensions and student achievement: Refining and extending the synthesis of data from multisection validity studies. Research in Higher Education, 30(6), 583-645.

- Frenay, M. (2006). Deux visions du rôle de l’enseignant. In B. Raucent & C. Vander Borght (Eds), Être enseignant : Magister ? Metteur en scène ? (pp. 26-31). Bruxelles, Belgique : De Boeck.

- Fréville, Y. (2002). Des universitaires mieux évalués, des universités plus responsables, Rapport d’information fait au nom du Comité d’évaluation des politiques publiques et de la Commission des finances, du contrôle budgétaire et des comptes économiques de la Nation sur la politique de recrutement et la gestion des universitaires et des chercheurs, (Rapport 54, 2001-2002) Paris, France, Les Rapports du Sénat, Paris, 2001. Extrait de http://www.senat.fr/rap/r01-054/r01-054.html.

- Houssaye, J. (1988). Le triangle pédagogique : théorie et pratiques de l’éducation scolaire. Berne, Suisse : Peter Lang.

- Jorro, A. (2007). Évaluation et développement professionnel. Paris, France : L’Harmattan.

- King, C. J., Ambrose, S. A., Arreola, R. A., & Watson, K. (2009). Developing Metrics for Assessing Engineering Instruction. What Gets Measured is What Gets Improved. Washington, DC: The National Academic Press. Extrait de http://www.nap.edu/catalog/12636.html.

- Lanarès, J. (2009) L’évaluation-conseil dans l’enseignement universitaire en Suisse. In V. Bedin (Ed.), L’évaluation à l’université : évaluer ou conseiller ? (pp. 211-232). Rennes, France : Presses universitaires de Rennes.

- Marsh, H. W. (1987). Students’ evaluations of university teaching: Research finding, methodological issues, and directions for future research. International Journal of Educational Research, 11(3), 255-388.

- Perret, C. (2010). Évaluation de la formation et des enseignements à l’uB. L3 Généralistes de l’uB, année 2009-10. Extrait de http://cipe.u-bourgogne.fr/images/stories/pdf/evaluation%20formations%20et%20enseignements%20l3%20bilan%202009%2010%20version%20courte.pdf.

- Petit, F. (2002). Améliorations pédagogiques à l’université. Paris, France : Ministère de l’Éducation nationale.

- Poissant, H. (1996). L’évaluation de l’enseignement universitaire. Montréal, Canada : Éditions Logiques.

- Rege Colet, N. (2002). L’arroseur arrosé : évaluation d’un service d’appui à l’évaluation de l’enseignement. Mesure et évaluation en éducation, 25(1), 19-45.

- Rege Colet, N. (2009). La place de l’évaluation formative dans le développement professionnel des enseignants-chercheurs. In V. Bedin (Ed.), L’évaluation à l’université : évaluer ou conseiller ? (pp. 275-293). Rennes, France : Presses universitaires de Rennes.

- Rege Colet, N., & Durand, N. (2009). Évaluation de l’enseignement à l’Université de Genève. Mesures d’impact sur les pratiques enseignantes. Extrait de http://www.unige.ch/formev/publications/evaluation-1/Mesure-impact-2005.pdf.

- Romainville, M. (2004). L’évaluation des acquis des étudiants dans l’enseignement universitaire (Rapport pour le Haut Conseil de l’évaluation de l’école). Paris, France : Haut Conseil de l’évaluation de l’école.

- Schön, D. A. (1993). Le praticien réflexif : à la recherche du savoir caché dans l’agir professionnel. Montréal, Canada, Éditions Logiques.

- Wigfield, A., & Eccles, J. S. (2000). Expectancy-value theory of achievement motivation. Contemporary Educational Psychology, 25(1), 68-81.

- Younès, N. (2007). À quelles conditions l’évaluation formative de l’enseignement par les étudiants est-elle possible en France ? Revue française de pédagogie, 161, 25-40.

- Younès, N. (2009). L’évaluation de l’enseignement par les étudiants comme seuil de changement. In M. Romainville & C. Coggi (Eds), L’évaluation de l’enseignement par les étudiants : approches critiques et pratiques innovantes (pp. 191-210). Bruxelles, Belgique : De Boeck.

List of figures

Figure 1

Utilisation des questions fournies par le CIPE pour la construction du questionnaire de l’EEE

Figure 2

Composition moyenne des questionnaires d’EEE

Figure 3

Poids moyen des différentes catégories de questions selon les domaines de formation

List of tables

Tableau 1

Poids moyens des différents types de questions de l’EEE

Tableau 2

Les thèmes exclus par les équipes pédagogiques

10.7202/000293ar

10.7202/000293ar